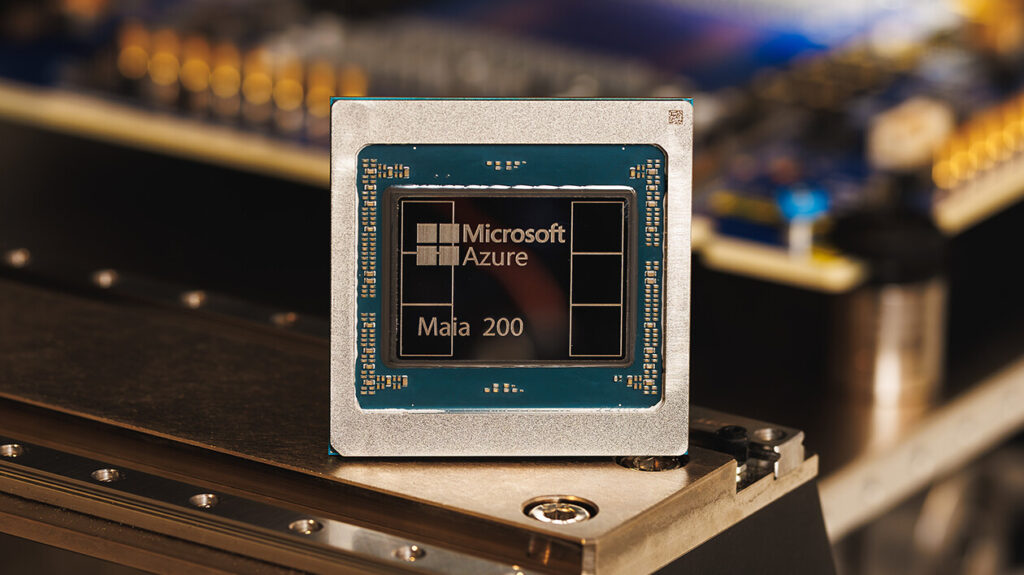

Microsoft yeni yapay zekâ hızlandırıcısı Maia 200’ü duyurdu. Bu çip, yapay zekâ modellerinin eğitiminden ziyade uygulamada “inference” denilen çalıştırma kısmında daha hızlı, daha verimli ve daha ekonomik performans sunmak üzere tasarlandı. Microsoft’a göre bu yeni hızlandırıcı, bulut bilişim altyapısı Azure’da çalışacak büyük ölçekli yapay zekâ modellerini işlemek için optimize edilmiş durumda ve şu ana kadar şirketin kullandığı donanımlar arasında dolar başına en yüksek performansı sunuyor.

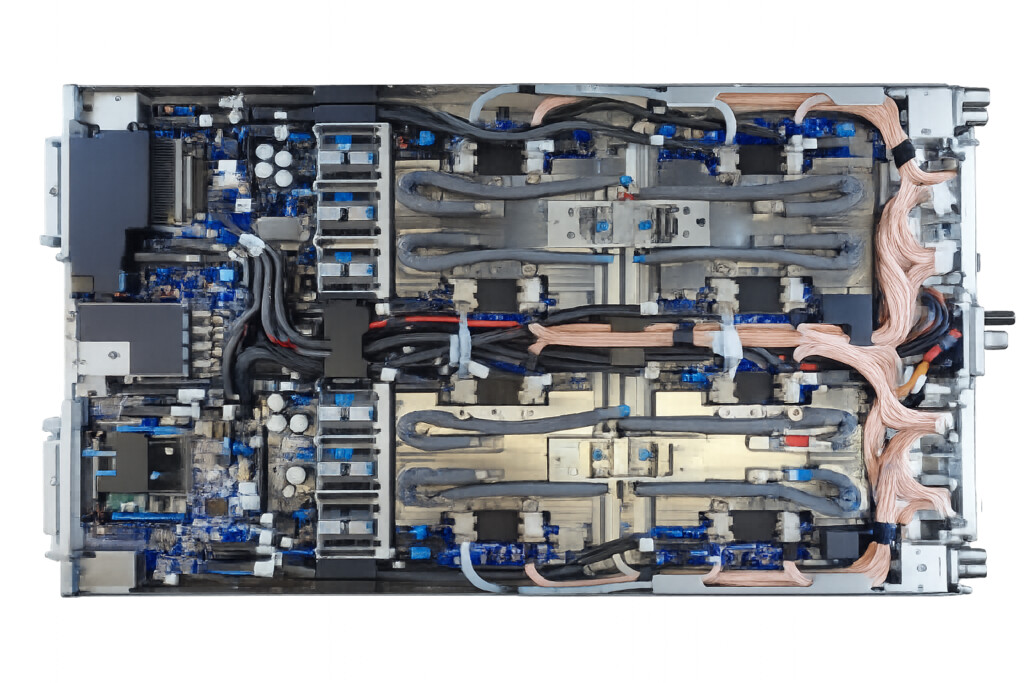

Maia 200, TSMC’nin 3 nanometre üretim sürecini kullanarak üretiliyor ve içinde yüz milyarların üzerinde transistör bulunuyor; düşük hassasiyetli FP4/FP8 hesaplamalarında son derece yüksek performans sağlıyor. Microsoft, bu çipin yalnızca kendi bulut hizmetlerinde kullanılacağını, özellikle OpenAI’nin GPT-5.2 modeli gibi büyük dil modelleriyle birlikte çalışacağını açıkladı. Azure’daki Microsoft 365 Copilot, Microsoft Foundry ve şirket içi “Superintelligence” ekiplerinin projeleri de Maia 200’den güç alacak şekilde planlanıyor.

Yeni çip Microsoft için aynı zamanda rekabet stratejisinin bir parçası: Amazon’un Trainium’ı ve Google’ın TPU’su gibi diğer büyük bulut sağlayıcılarının yapay zekâ hızlandırıcılarına karşı daha güçlü ve özelleştirilmiş bir alternatif yaratmayı hedefliyor. Microsoft bu sayede donanım ve yazılım yığını üzerinde daha fazla kontrol sahibi olmak ve dışa bağımlılığı azaltmak istiyor.

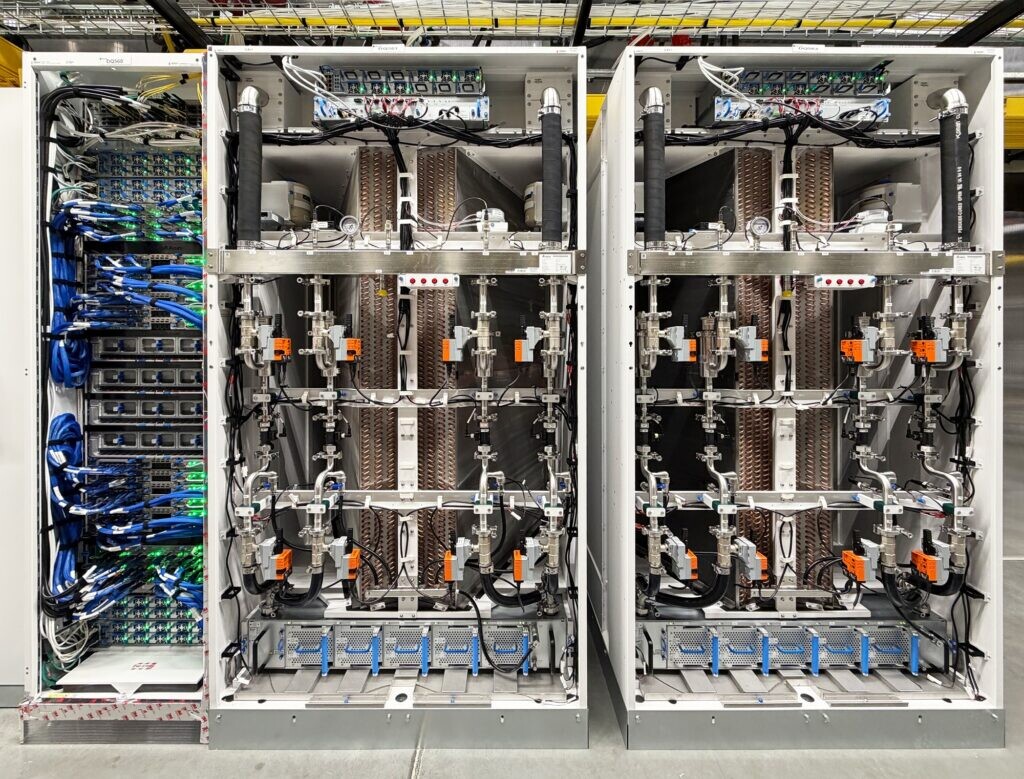

Şu anda Maia 200, ABD’deki Azure veri merkezlerinde devreye alınmaya başlandı ve daha fazla bölgeye yayılması planlanıyor. Buna paralel olarak geliştiriciler için PyTorch desteği, Triton derleyicisi ve özel SDK gibi araçları içeren bir yazılım geliştirme kiti de sunuluyor, böylece modeller bu yeni donanım üzerinde kolayca optimize edilebilecek.